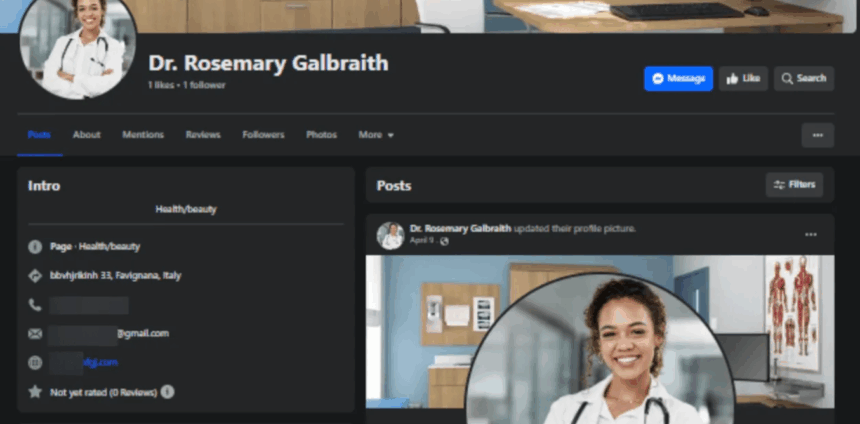

Você abre as redes sociais e se depara com uma publicação da Dra. Rosemary Galbraith, referência em saúde em Favignana, na Itália. No perfil de Rosemary, uma foto de jaleco branco, estetoscópio no pescoço e conteúdos com voz pausada de autoridade. Ela fala sobre curas milagrosas, suplementos secretos e terapias revolucionárias. O problema? A Rosemary não existe. E na verdade é apenas uma dentre as mais de 1.000 contas falsas identificadas na META, criadas por inteligência artificial, para promover curas milagrosas.

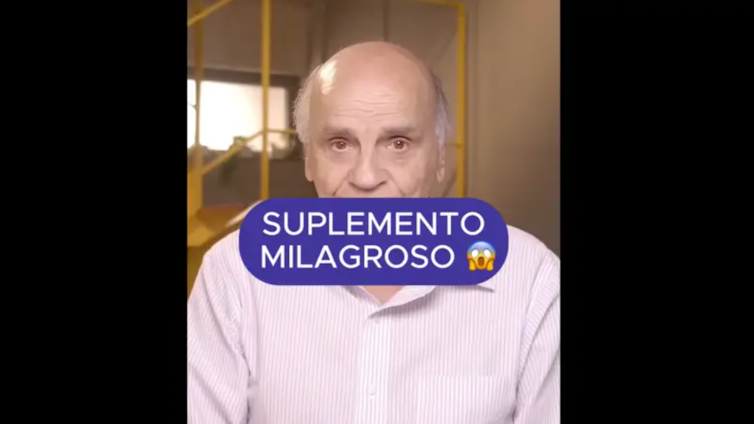

Nem precisamos cruzar o oceano, o próprio médico Drauzio Varella já denunciou diversas vezes como golpistas estão usando o seu rosto e a sua voz em vídeos com inteligência artificial para vender desde colágeno milagroso, até receitas para supostamente curar artrose, osteoporose e remover dores nos joelhos. Drauzio relatou que até tentou acionar as Big Techs, mas, depois de muito insistir, chegou à conclusão que “[as Big Techs] simplesmente não dão bola”. Trata-se da credibilidade de uma vida inteira dedicada à medicina, sequestrada em segundos por algoritmos.

Com ferramentas como o Veo 3, a nova IA de vídeos do Google, qualquer rosto ou voz pode ser sequestrado. A IA virou um pincel que reproduz com fidelidade a pose de autoridade. Mas se a arte falsificada apenas confunde museus, a ciência falsificada pode matar. E é nesse novo palco digital, onde a confiança virou recurso explorável, que a divulgação científica passa a ser alvo. Drauzio é conhecido, um dos precursores da divulgação científica em saúde no Brasil. Mas e quando um médico de uma cidade pequena tem o seu rosto, a sua voz e o seu CRM sequestrados para sustentar um lucrativo mercado que abusa da omissão das plataformas?

Quando o jaleco vira figurino

Ainda na área da saúde, a urologista Kgomotso Mathabe, da África do Sul, teve sua imagem usada em propagandas de tratamentos para disfunção erétil, com seu rosto sendo adicionado a vídeos e anúncios que prometiam curas duvidosas.

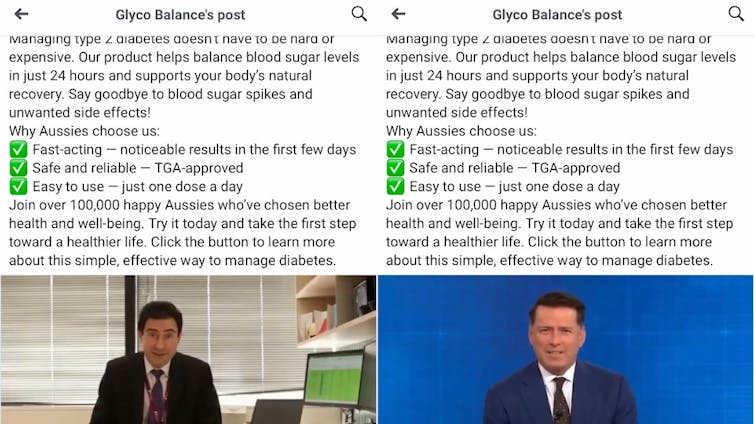

Já Jonathan Shaw, endocrinologista e vice‑diretor do Baker Heart and Diabetes Institute (Austrália), foi alvo de deepfakes, as quais o acusavam de criticar prescrições de metformina e atacavam colegas médicos, associando seu nome a um produto milagroso para diabetes.

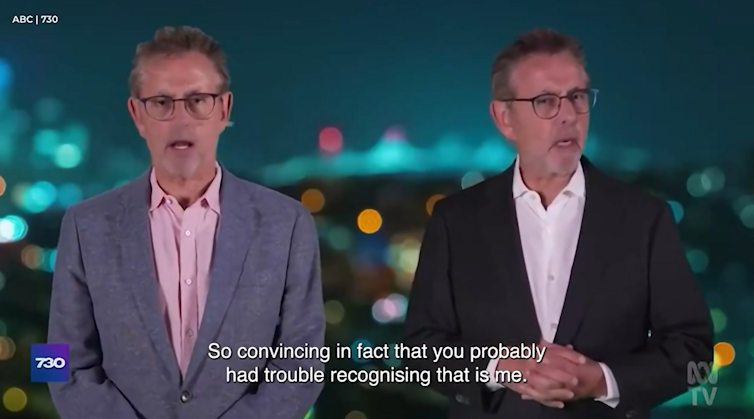

Em um exemplo de como a imprensa também é capturada, na Austrália, Norman Swan, apresentador do programa ABC 7.30, apareceu em uma deepfake promovendo suplementos para doenças cardíacas e diabetes. O vídeo enganou até apresentadores do canal, e especialistas estimam que esses golpes causaram perdas de mais de US$ 2 bi em fraudes em apenas um ano.

O problema, porém, não se limita à saúde. A estética acadêmica também foi cooptada. Textos com linguagem formal, gráficos coloridos, citações sofisticadas e aparência de peer-reviewed circulam como se fossem pesquisa científica legítima, mas, na realidade, são peças de desinformação. Ferramentas como ChatGPT, Gemini ou Claude podem gerar textos completos com seções estruturadas, formatação de artigo, referências falsas, DOIs inventados e até supostas afiliações institucionais. Esses “papers” falsos são usados para promover dietas radicais, negar o aquecimento global, distorcer estatísticas de violência, ou disseminar mentiras sobre vacinas, usando a aparência de autoridade acadêmica para enganar.

Nem mesmo o mercado editorial científico tem saído impune. A pesquisadora Isabela Rocha (UnB) inclusive denunciou no The Conversation Brasil sobre como a publicação de livro com citações falsas expõe mercado que valoriza mais o prestígio do que rigor científico.

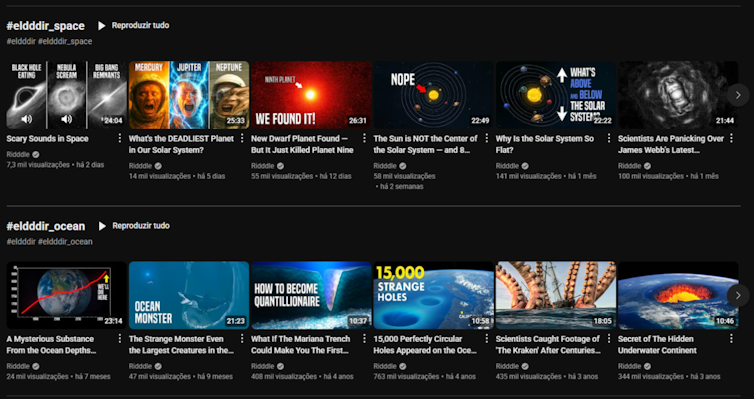

Um dos casos mais alarmantes vem da própria BBC, que investigou como a inteligência artificial está sendo usada para enganar crianças com vídeos de “ciência” falsificada. A reportagem revelou dezenas de canais no YouTube, produzidos em diferentes idiomas, que usam vozes sintetizadas por IA e imagens chamativas para espalhar desinformação sobre temas como física, biologia e história. São os chamados “canais dark”, que não precisam de um rosto, mas apenas uma voz com imagens geradas por IA. Com estética limpa, linguagem simplificada e ritmo acelerado, esses vídeos simulam o tom de canais educativos legítimos, mas difundem teorias pseudocientíficas, como pirâmides que geram energia ou curas imediatas por frequência sonora.

O algoritmo do YouTube, em muitos casos, recomenda esses conteúdos logo após vídeos confiáveis de ciência, criando um efeito de associação perigoso: o público infantil passa a consumir, sem perceber, uma narrativa embalada como conhecimento, mas programada para confundir. A crise da divulgação científica não está só no que é dito, mas em quem é enganado e nesse caso, é o futuro quem está sendo manipulado.

É importante retomar que a divulgação científica não é apenas uma ponte entre cientistas e o público. Ela é um pacto social. Uma forma de tornar o conhecimento acessível, de combater desigualdades no acesso à informação, de estimular o pensamento crítico. Desde revistas populares a vídeos no YouTube, ela cumpre a função democrática de aproximar a sociedade da produção do saber. Mas esse pacto começa a ruir quando o que se apresenta como ciência é, na verdade, simulação. A confiança na ciência não nasce do jaleco ou do tom pausado de voz. Ela é construída historicamente por métodos, revisão por pares, transparência e correções.

A inteligência artificial, ao replicar apenas a estética da ciência, com citações, gráficos e vocabulário técnico, sem o método, promove uma caricatura do saber. E a caricatura, quando passa por verdade, transforma a dúvida legítima em confusão programada.

É nesse contexto que a maior vítima da fraude científica gerada por IA não é apenas o indivíduo enganado, mas a confiança pública no conhecimento como bem coletivo. Quando o público não consegue mais distinguir o que é ciência e o que é fraude, tudo vira questão de opinião. E nesse terreno da incerteza fabricada, o negacionismo encontra solo fértil.

Transparência e responsabilização como antídoto

O que está em jogo não é apenas a precisão de um conteúdo aqui ou ali. É a própria ideia de ciência como um bem coletivo. A divulgação científica sempre foi mais do que uma ponte entre o laboratório e a sociedade, ela é um compromisso com o entendimento público, um esforço para tornar o conhecimento acessível sem abrir mão do rigor. Mas esse pacto começa a ruir quando qualquer vídeo com voz pausada e jaleco animado por IA passa a circular como se fosse descoberta, evidência, estudo. Quando a verdade científica vira efeito especial.

Por isso, não basta discutir moderação genérica. É preciso criar protocolos específicos para proteger a ciência do sequestro digital. Conteúdos que usam voz, rosto ou texto gerado por IA com estética científica, especialmente em temas como saúde, meio ambiente e educação, devem ser obrigatoriamente rotulados, com marcações visíveis e auditáveis. Porque simular um pesquisador para vender mentira é diferente de fazer arte digital: é falsificar credencial. É vestir o figurino da ciência para encenar o enredo do engano.

As plataformas, por sua vez, não podem continuar fingindo que são só palco neutro. YouTube, Instagram, TikTok e afins precisam adotar filtros éticos: se já conseguem identificar música com copyright, também podem identificar vídeos que simulam autoridade médica ou acadêmica. Especialmente quando esses conteúdos são recomendados a crianças, jovens ou públicos em situação de vulnerabilidade. Se lucram com o alcance, têm responsabilidade sobre o estrago.

E talvez o ponto mais estrutural: disseminar ciência hoje é também estimular a duvidar do que se veste como ciência, mas não foi construída como tal. A alfabetização científica precisa sair da bolha do ensino formal e entrar na cultura digital. Formar o olhar crítico para distinguir linguagem técnica de rigor metodológico. Mostrar que citação não é prova, gráfico não é evidência, e voz grave não é sinônimo de autoridade.

Porque proteger a divulgação científica não é apenas sobre proteger os pesquisadores. É proteger o direito das pessoas a decidirem com base em realidade, e não em versões renderizadas. Se tudo pode parecer ciência, até o absurdo, o diálogo vira disputa de aparência. E nesse teatro da simulação, o que se perde não é só a verdade: é a confiança, a curiosidade, a possibilidade de aprender. A IA não precisa mentir para desinformar. Basta que ela espalhe ruído até que ninguém mais saiba em quem confiar. Mas quando a ciência é capturada por um modelo de negócio que depende mais do engajamento do que dos fatos, como competir com o que mente melhor?